GHM总结

论文名称:Gradient Harmonized Single-stage Detector

论文地址:传送门

Introduction

single-stage detector虽然面临着训练时的不协调,如正样本和负样本、易分类目标和难分类目标之间质量的巨大差异,但其不失为一种优雅且有效的方法。

在本文中,作者将这种不协调性归结到梯度问题,并提出了一种梯度协调机制(Gradient Harmonizing Mechanism,GHM)来解决这种不协调。GHM可以与分类和回归Loss function相结合,如Cross Entropy、Smooth L1 Loss。

我们知道在one-stage方法的训练过程中,最大的挑战就是正样本和负样本、易分类目标和难分类目标之间的不平衡性,大量易分类的背景样本使得模型并不能学习到目标的真正特征。如果一个目标很容易区分,那么模型并不能从中受益。

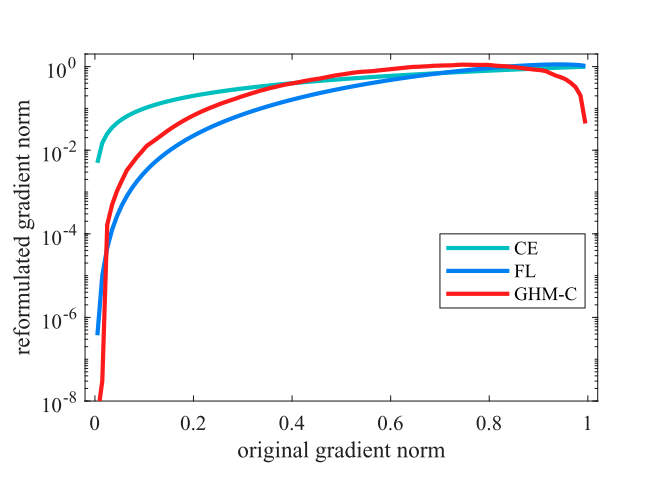

梯度范数等效于梯度的大小,范数越大,则梯度就较大。作者通过对梯度范数的分析,发现梯度范数较小时聚集了大量的样本,而这些样本即代表易分类的样本,它们对模型的训练并没有太大的帮助;同时我们还发现有许多梯度范数及其大的样本,他们对目标的分类也没有太大的作用。

因此如果能够对梯度范数十分小的样本和十分大的样本(异常值,outliers)down-weight,那么每个样本的贡献都是均衡的。

Gradient Harmonizing Mechanism

对于二分类问题的Loss函数:Cross Entropy

$$L_{CE}(p,p^)=\begin{cases}

-log§ && if \quad p^=1 \

-log(1-p) && if \quad p^*=0

\end{cases}$$

假设$p=sigmoid(x)$,那么:

$$\frac{\partial L_{CE}}{\partial x}=\begin{cases}

p-1 && if \quad p^=1 \

p && if \quad p^=0

\end{cases}

=p-p^*

$$

接着我们定义$g$:

$$g = |p-p^|=\begin{cases}

1-p && if \quad p^=1 \

p && if \quad p^*=0

\end{cases}$$

Gradient Dentisy

$$GD(g)=\frac{1}{l_{\epsilon}(g)}=\sum_{k=1}^N\delta_{\epsilon}(g_k,g)$$

$$\delta(x,y)=\begin{cases}

1 && if \quad y-\frac{\epsilon}{2} <= x < y+ \frac{\epsilon}{2} \

0 && otherwise

\end{cases}$$

$$

l_{\epsilon}(g)=min(g+\frac{\epsilon}{2},1)-max(g-\frac{\epsilon}{2},0)

$$

接着定义梯度密度协调参数$\beta_i=\frac{N}{GD(g_i)}$,其中N是样本总数。

GHM-C Loss

将GHM加入到分类Loss当中:

$$L_{GHM-C}=\frac{1}{N} \sum_{i=1}^{N}\beta_i L_{CE}(p_i,p^)

\= \sum_{i=1}^N \frac{L_{CE}(p_i,p^)}{GD(g_i)}

$$

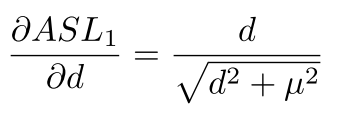

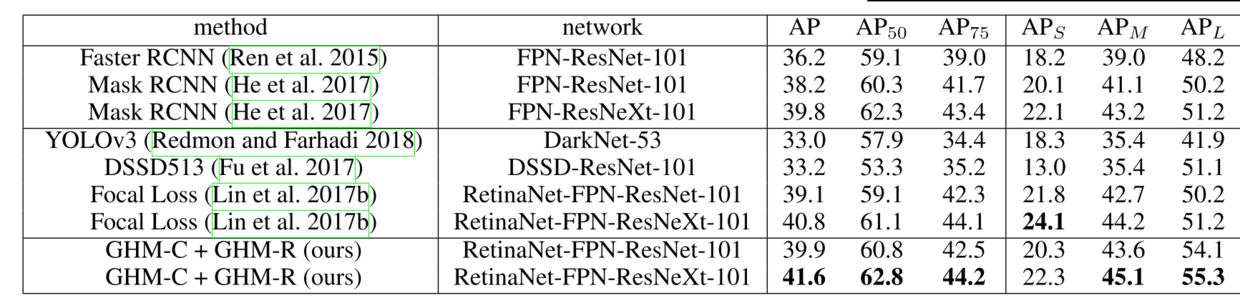

GHM-R Loss

在回归当中使用的L1 Loss:

$$L_{reg}=\sum_{i \in {x,y,w,h}}SL_1(t_i-t_i^*)$$

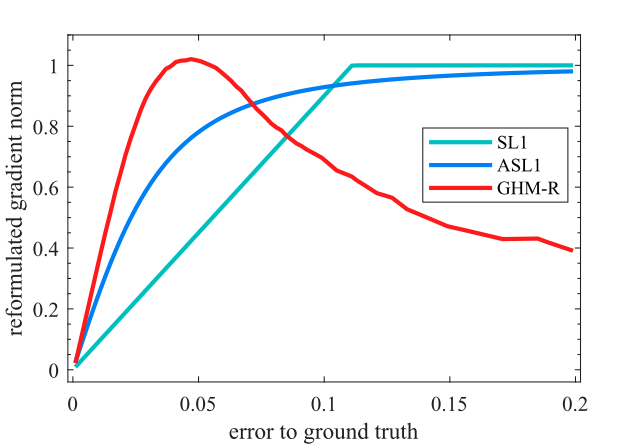

Experiments

本博客所有文章除特别声明外,均采用 CC BY-SA 4.0 协议 ,转载请注明出处!